多亏了 Meta LLaMA,AI 文本模型才有了它们的“稳定扩散时刻”。

AI Land 中的事物正在以闪电般的速度发展。周五,一位名叫 Georgi Gerganov 的软件开发人员创建了一个名为“llama.cpp”的工具,可以在 Mac 笔记本电脑本地运行 Meta 的新 GPT-3 类 AI 大型语言模型LLaMA 。此后不久,人们也想出了如何在 Windows 上运行 LLaMA。然后有人展示了它在 Pixel 6 手机上运行,接下来是Raspberry Pi(尽管运行速度非常慢)。

如果这种情况持续下去,我们可能会在不知不觉中看到一个口袋大小的ChatGPT 竞争对手。

但是让我们后退一分钟,因为我们还没有到那一步。(至少不是今天——实际上是今天,2023 年 3 月 13 日。)但是下周会发生什么,没人知道。

自ChatGPT 推出以来,一些人对 AI 模型的内置限制感到沮丧,这些限制阻止它讨论 OpenAI 认为敏感的话题。因此,在某些方面开始了开源大型语言模型 (LLM) 的梦想,任何人都可以在本地运行而无需审查,也无需向 OpenAI支付API 费用。

开源解决方案确实存在(例如GPT-J),但它们需要大量的 GPU RAM 和存储空间。其他开源替代品无法在现成的消费级硬件上拥有 GPT-3 级性能。

输入 LLaMA,这是一个参数大小范围从 7B 到 65B 的 LLM(在“十亿参数”中是“B”,它们是存储在矩阵中的浮点数,表示模型“知道”的内容)。LLaMA 做出了令人振奋的声明:其较小尺寸的模型在输出质量和速度方面可以与OpenAI 的 GPT-3(为 ChatGPT 提供支持的基础模型)相媲美。只有一个问题——Meta 发布了 LLaMA 代码开源,但它只为合格的研究人员保留了“权重”(存储在神经网络中的经过训练的“知识”)。

以 LLaMA 的速度飞行

Meta 对 LLaMA 的限制并没有持续多久,因为在 3 月 2 日,有人泄露了 BitTorrent 上的 LLaMA 权重。从那时起,围绕 LLaMA 的开发就出现了爆炸式增长。独立 AI 研究员西蒙·威利森 (Simon Willison) 将这种情况与去年 8 月推出的开源图像合成模型Stable Diffusion 的发布进行了比较。这是他在博客上的一篇文章中写的:

在我看来,8 月份的稳定扩散时刻开启了对生成式 AI 的全新兴趣浪潮——然后在 11 月底发布的 ChatGPT 将其推向了超速发展。

对于大型语言模型(ChatGPT 本身背后的技术)来说,稳定扩散时刻正在再次发生。今天早上,我第一次在自己的个人笔记本电脑上运行了 GPT-3 类语言模型!

人工智能的东西已经很奇怪了。这将变得更加奇怪。

通常,运行 GPT-3 需要多个数据中心级A100 GPU(此外,GPT-3 的权重不公开),但 LLaMA 引起了轰动,因为它可以在单个强大的消费类 GPU 上运行。现在,通过使用一种称为量化的技术来减小模型大小的优化,LLaMA 可以在 M1 Mac 或较小的 Nvidia 消费级 GPU 上运行(尽管“llama.cpp”目前仅在 CPU 上运行——这在它自己的方式)。

事情发展得如此之快,以至于有时很难跟上最新的发展。(关于 AI 的进步速度,一位 AI 记者告诉 Ars,“这就像那些狗的视频,你把一箱网球倒在它们身上。[他们] 不知道先追哪里,然后在混乱中迷路。 ")

例如,以下是根据 Hacker News 评论中 Willison 列出的时间表列出的与 LLaMA 相关的著名事件列表:

- 2023 年 2 月 24 日:Meta AI宣布LLaMA。

- 2023 年 3 月 2 日:有人通过 BitTorrent泄露了 LLaMA 模型。

- 2023 年 3 月 10 日:Georgi Gerganov创建了 llama.cpp,它可以在 M1 Mac 上运行。

- 2023 年 3 月 11 日:Artem Andreenko在 Raspberry Pi 4、4GB RAM、10 秒/令牌上运行 LLaMA 7B(缓慢)。

- 2023 年 3 月 12 日:在node.js 执行工具NPX 上运行LLaMA 7B。

- 2023 年 3 月 13 日:有人在 Pixel 6 手机上运行 llama.cpp ,速度也很慢。

- 2023 年 3 月 13 日,2023 年:斯坦福发布了Alpaca 7B,这是 LLaMA 7B 的指令调整版本,“其行为类似于 OpenAI 的” text-davinci-003 “,但在功能较弱的硬件上运行。

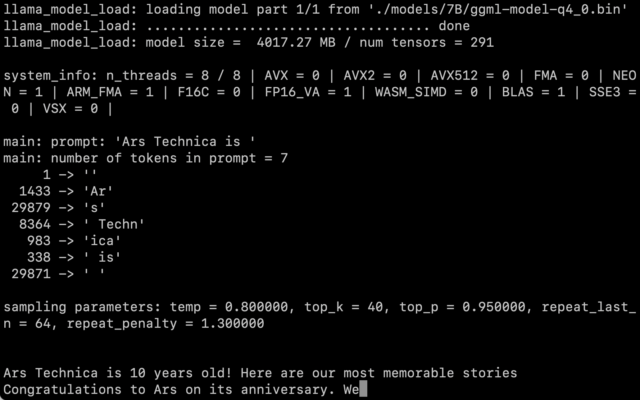

我们自己获取了LLaMA权重后,按照Willison的说明,得到了在M1 Macbook Air上运行的7B参数版本,运行速度还算合理。您在命令行上将其作为脚本调用并带有提示,LLaMA 会尽力以合理的方式完成它。

仍然存在量化对输出质量的影响有多大的问题。在我们的测试中,将 LLaMA 7B 削减至 4 位量化对于在 MacBook Air 上运行来说非常令人印象深刻——但仍不及您对 ChatGPT 的预期。更好的提示技术完全有可能产生更好的结果。

此外,当每个人都掌握代码和权重时,优化和微调会很快出现——即使 LLaMA 仍然背负着一些相当严格的使用条款。斯坦福大学今天发布的 Alpaca证明了微调(针对特定目标的额外训练)可以提高性能,而 LLaMA 发布还处于早期阶段。

在撰写本文时,在 Mac 上运行 LLaMA 仍然是一项相当技术性的练习。您必须安装 Python 和 Xcode 并熟悉在命令行上工作。威利森为任何想尝试的人提供了很好的分步说明。但随着开发人员继续编写代码,这种情况可能很快就会改变。

至于在野外使用这项技术的意义——还没有人知道。虽然有些人担心人工智能作为垃圾邮件和错误信息工具的影响,但威利森说,“它不会被发明出来,所以我认为我们的首要任务应该是找出最具建设性的可能方式来使用它。”

现在,我们唯一的保证是事情会迅速改变。

如若转载,请注明出处:https://www.ozabc.com/un/535450.html